Figura 1.

¡Abramos el discurso científico! La revisión abierta por pares. Una opción para transparentar las decisiones científicas

0 commentsPosted in Artículos | Vol. 1 | Núm. 1 | 2015

| Autor | Arturo Silva Rodríguez |

| Temáticas |

Revisión abierta por pares | Revisión por pares doble ciego | Acceso abierto | Decisiones científicas transparentes | Fraudes en la ciencia |

| Tipo de Contribución | Artículo Editorial |

| Referencia |

Silva, R. A. (2015). ¡Abramos el discurso científico! La revisión abierta por pares. Una opción para transparentar las decisiones científicas. Revista Digital Internacional de Psicología y Ciencia Social, 1(1), 15-31. |

- Introducción

- La Producción Científica en el Mundo

- La Estrategia de Revisión por Pares

- Los Desafíos de la Revisión por Pares

- La Revisión Abierta por Pares en la RDIPyCS

- Modelo de Evaluación Abierta por Pares de la RDIPyCS

- Discusión

- Conclusiones

- Referencias

| La mayoría del conocimiento científico se difunde a través de revistas que publican artículos que son revisados o dictaminados por pares, y en donde se recogen las contribuciones individuales de los científicos, quienes con esto establecen y fijan los parámetros de las fronteras de dicho campo. Esto contribuye a la construcción del cúmulo de conocimientos de un campo específico de la ciencia.

El impacto de la evaluación científica por pares va más allá de un simple dictamen sobre la factibilidad de publicar o no un artículo que reporta un determinado hallazgo, ya sea éste teórico, empírico, metodológico o aplicado. De esta forma, la evaluación se convierte en una herramienta poderosa que establece las dimensiones y fija los parámetros de lo que se acepta como producción científica, avance o resultado de investigación (Sánchez, 2011). A través de ella, y de la difusión de los hallazgos que pasaron el escrutinio de los pares, se crea opinión y se fijan las fronteras de los avances en determinados campos del conocimiento. Este hecho convierte al fruto de la evaluación por pares de la producción del conocimiento en un reflejo fiel de cómo la comunidad científica va construyendo sus visiones del mundo, en donde confluyen aspectos filosóficos, religiosos, políticos, de la vida cotidiana, laborales, personales, etc. La confluencia de estos aspectos hace que la evaluación por pares se convierta en una herramienta poderosa que dicta las reglas de cómo se hace la ciencia, en donde se recoge además la manera de cómo los científicos hilvanan los distintos saberes para construir las visiones de los múltiples campos de conocimiento, que se convierten finalmente en las ideas dominantes en la sociedad respecto a la naturaleza de un determinado campo de conocimiento. De ahí la importancia de dichas evaluaciones por pares, puesto que a través de ellas es posible conocer la forma en que los científicos van moldeando, cual plastilina, a la ciencia, convirtiendo a esta última en un espejo nítido del pensamiento de los científicos. Es una de las muchas maneras en que los científicos establecen los consensos entre los distintos paradigmas reduciéndolos a uno, lo que origina la aparición del pensamiento científico normal de la época, que define el tipo de problema que hay que estudiar, los criterios con los que se debe evaluar una solución y los procedimientos de investigación que se consideran aceptables (Kuhn, 1992). La vigencia de este pensamiento normal persistirá mientras no aparezcan rupturas epistemológicas sin solución a la luz de la ciencia normal, una vez que éstas surjan será el comienzo del ciclo eterno crisis-consenso. La evaluación por pares se vuelve una especie de sociología del conocimiento que relaciona la producción científica de un grupo con el ideal de ciencia de la época que es adoptada por nosotros para ponernos en contacto con la comunidad científica global. Así pues, se convierte en una herramienta crítica para valorar y medir los parámetro de calidad, factibilidad y credibilidad de la producción científica de acuerdo al ideal de ciencia normal de la época, lo que la convierte políticamente hablando, en un espacio social de disputa de valores y de poder. En suma, es una pieza angular de la que depende la ciencia, ya que se pone en sus manos la potestad de definir las características y los límites de la ciencia. En este contexto científico, social y político se desarrolla el presente artículo en donde se fundamenta la línea editorial de la Revista Digital Internacional de Psicología y Ciencia Social (RDIPyCS) que sigue una política de revisión abierta por pares u OPR por sus siglas en inglés Open Peer Review. El artículo comienza abordando la forma actual que guarda la producción científica en el mundo; posteriormente se describe el papel estratégico que tiene en la ciencia la revisión por pares, así como los desafíos que enfrenta. Finalmente se presentan las principales característica de la línea editorial que adopta la revista relacionada con en la revisión abierta por pares, haciendo un breve bosquejo del modelo de evaluación que usa para hacer las revisiones de los manuscritos. |

|

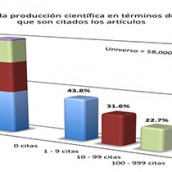

Recientemente la prestigiosa revista Nature hizo una comparación interesante tomando como punto de referencia la producción de artículo científicos desde 1900 a la fecha para encontrar los 100 artículos más citados. El universo resultante fue de 58 millones de artículos desde ese año hasta ahora, con lo que se puede construir una torre de 5,800 metros si se apilaran solamente las páginas frontales de cada uno de esos artículos, que es aproximadamente del tamaño del pico más alto de monte Kilimanjaro en Tanzania (van Noorden, Maher, & Nuzzo, 2014). Este hecho podría quedar sólo en el anecdotario de las cosas curiosas, si únicamente se viera muy al estilo del “Asombroso Mundo de Ripley”; sin embargo, al relacionarlo con tres conceptos que se han endiosado en la época actual para medir el impacto y la calidad de la producción científica, los resultados encontrados son realmente sorprendentes y reveladores. Es de todos conocido la importancia que tiene en el discurso de los que administran la ciencia -y del cual algunos investigadores lamentablemente también lo han adoptado-, la medición de los índices de impacto y la calidad de las publicaciones en función de la teoría o marco teórico del que se parte, del número de citas que se hacen del artículo publicado y del factor de impacto de la revista en donde se publica. De todo este cúmulo de artículos, como se observa en la figura 1, el 43.8% nunca ha tenido ninguna cita, lo que corresponde alrededor de 25,332,701 artículos, y que en términos de su magnitud equivaldría a una altura aproximada más o menos de 2,600 metros, que formaría una torre casi nueve veces más alta que la Torre Eiffel. Por consiguiente, desde la mirada de los administradores de la ciencia, la conclusión a la que se podría llegar es que este porcentaje de la producción científica del mundo no tiene impacto ya que nunca es citada, y algunas miradas interpretativas más radicales dudarían de su calidad y emprenderían acciones encaminadas a reducir los fondos para la investigación. Desde esas miradas interpretativas basadas exclusivamente en la evidencia de los números, la alarma aumentaría, puesto que otra porción muy grande, que corresponde a la nada despreciable cantidad de 18,280,005 artículos, sólo han sido citados entre uno y nueve veces. Sumando estas dos cantidades se arroja la sorprendente cantidad de 43,612,706 de artículos que ha sido citados a lo más nueve veces, lo que corresponde a la fabulosa cantidad de 75.5% de toda la producción en la ciencia. Ante la contundencia de esta evidencia, los administradores de la ciencia estarían llamando a la cruzada internacional en todos los frentes para cortar los recursos a los investigadores, dado que el índice de impacto de su producción científica es muy bajo, ya que casi nunca, sólo por no decir nunca, sus trabajos son citados. Otro hecho revelador de este estudio es que contrario a lo que se pudiera pensar, los artículo más citados no son aquellos que informan de los descubrimientos conceptuales más grandes, sino aquellos que describen métodos experimentales de laboratorio, de bioinformática o estadísticos, por lo que como refieren van Noorden, Maher y Nuzzo (2014), al relatar en una entrevista que tuvieron con un científico de la Universidad de Yale, proponer una técnica experimental o un método estadístico para calcular un determinado índice lleva más lejos, casi a la cima del Kilimanjaro de los artículos citados, que descubrir el secreto del universo. En cuanto a los métodos estadísticos, actualmente más cercanos a la investigación que se hace en psicología, dada la hegemonía que tiene en estos momentos el uso del análisis cuantitativo; en la lista de los 100 artículos más citados se ubican varios; sin embargo, como dice el experto en estadística de la Universidad de Chicago en Illinois, Stephen Stigler “… el hecho de estar varios de ellos en los 100 artículos más citados no han sido para nosotros los estadísticos los más importantes, lo único que indica es que ese método es el que más han utilizado los científicos que practican el análisis cuantitativo de sus datos” (van Noorden, Maher y Nuzzo, 2014, p. 552). Por ejemplo el método de Kaplan y Meier (1958) sobre el análisis no paramétrico de supervivencia ocupa el lugar 11, por su parte el método de Cox (1972) para análisis de riesgo el lugar 24, mientras que el 29 corresponde al método de Bland y Altman (1986) en donde se proponen un procedimiento para determinar la manera en que dos métodos de medición clínica concuerdan entre ellos; en la lista de los 100 más citados se ubica también el método de comparaciones múltiples de Duncan (1955), el cual ocupa el lugar 65, (para ver la lista completa del estudio de la revista Nature diríjase a este vínculo). Un hecho que sale a la luz a partir de este análisis es que los artículos más famosos y que han influido significativamente en el conocimiento científico no aparecen en la lista de los 100 más citados de todos los tiempos, a pesar de que sus autores han ganado Premios Nobel y el reconocimiento internacional por sus aportaciones a la ciencia. Entre ellos se encuentran, por ejemplo, el descubrimiento de los superconductores de alta temperatura, la determinación de la estructura de doble hélice del ADN, las primeras observaciones de que la expansión del Universo se está acelerando (van Noorden et al., 2014). Al margen de estas ausencias en dicha lista, es innegable que las citas que se hacen a trabajos anteriores es un indicador de cómo los autores reconocen la fuente de sus métodos, ideas y conclusiones. Este hecho los administradores de la ciencia lo han llevado más allá de lo que explícitamente es, al equipar el número de veces que un artículo es citado como una medida confiable y válida de la importancia e impacto de un documento. Desde esta perspectiva se podría llegar a la falsa conclusión de que el 75.5%, que corresponde a la cantidad de 43,612, 706, de artículos publicados desde 1900 a la actualidad no han sido importantes ni han tenido impacto porque sólo han sido citados no más de nueve veces y los más radicales se atreverían a decir que no sirvieron para nada. Estos juicios estarían pasando por alto que miles de personas que no escriben también son ávidos lectores de la literatura científica y al no escribir obviamente no citarán por escrito, pero sí muy probablemente citarán el artículo de boca en boca, es decir, de manera oral, o bien utilizando las redes sociales, las cuales caen fuera de las bases de datos de las revistas científicas periódicas que son analizadas para obtener el índice de impacto de un determinado documento. De igual manera, existen muchos artículos que son leídos por los investigadores, de los cuales extraen ideas para sus métodos y conclusiones, pero que por alguna causa no citan. Además una práctica común en la ciencia es que los descubrimientos verdaderamente fundamentales -por ejemplo, la teoría especial de la relatividad de Einstein, que ha sido una de las mayores revoluciones en la ciencia moderna y que modificó por completo la comprensión newtoniana del universo-, rápidamente se hacen tan comunes que son incorporados a los libros de texto haciéndolos tan familiares que no necesitan ser citados, por lo que reciben menos citas de las que merecen. Finalmente, una creencia más que se debilita a partir del estudio de van Noorden et al., (2014) es la tan poco cuestionada idea de la relación directa que se establece entre la calidad del conocimiento que se aborda en un determinado artículo y el factor de impacto de la revista en donde se publica, puesto que por lo general se establece que la producción científica de un investigador es de mejor calidad si la mayoría de sus artículos los ha publicado en una revista de alto impacto. Sin embargo, no necesariamente esto es así, puesto que como menciona Gamba (2014), entre los 100 artículos más citados, seis 6 de ellos fueron publicados en revistas con un factor de impacto del 1.99 y otros dos que ocupan el lugar 51 y 96, el factor de impacto de las revistas en donde aparecieron es de 0.84 y 0.93 respectivamente, mientras que sólo 15 de esos 100 artículos fueron publicados en revistas con un factor de impacto mayor a 10, los restantes en revistas con factores de impacto que van de 2 a 5. De esta manera la generalización que hacen los administradores de la ciencia para evaluar la calidad de la productividad de los científicos tomando como punto de referencia el factor de impacto de las revistas es una extrapolación sin un fuerte sustento. Resulta paradójico que los investigadores que son los más fervientes defensores de que los instrumentos utilizados en la recolección de información, ya sea cuantitativa o cualitativa, sean confiables y válidos, adopten de manera irreflexiva, cuando se les pide evaluar la productividad de sus pares, un indicador que fue construido y validado para valorar la calidad de las revistas científicas no la calidad del conocimiento publicado por los investigadores. Los hallazgos encontrados en el estudio de van Noorden et al. (2014) realizado a petición de la Revista Nature son muy parecidos a la lista de los artículos más citados generada por Google Académico que se basó en lo publicado en Web. Una diferencia es que en este último estudio se integró además de artículos la categoría de libros, lo que mostró que existen libros que se han convertido en pilares en la generación de conocimiento al considerar el número de veces que son citados. Cabe destacar que en el lugar seis se ubica el libro de Metodología de investigación longitudinal de Yin (1984) e inmediatamente por debajo de éste, en el lugar siete, el libro de Kuhn (1992) que aborda el tema de cómo surgen las revoluciones científicas en la ciencia. Otros libros que se han vuelto clásicos en la psicología y en las ciencias sociales, y que aparecen en la lista son Glaser y Strauss (1967) sobre análisis cualitativo, lugar 12; Nunnally, Bernstein, y Berge (1967) sobre psicometría, lugar 16; Siegel (1957) relacionado con la estadística no paramétrica, lugar 28; Vygotsky (1980) que aborda el desarrollo de los procesos psicológicos superiores, lugar 32, y algunos otros relacionados con el análisis cuantitativo y cualitativo en las ciencias sociales (para ver la lista completa de Google Académico diríjase a este vínculo). La diferencia más marcada entre ambas es que en la lista de Google Académico dos terceras partes de los 100 más citados están compuestas por libros, categoría que no se incluyó en la lista de Nature, pero en la parte superior de ambas listas aparecen los mismos tres artículos de investigación, aunque en diferente orden: los que ocupan en la revista Nature el primero, segundo y tercer lugares, en Google Académico tienen el segundo, primer y el tercer lugar. Otro hecho de resaltar es que en el estudio de Google Académico más de un tercio de la lista es diferente a la de Nature y en la cual predominan artículos de economía y psicología. |

|

La revisión por pares se ha vuelto en la actualidad el proceso por excelencia para la toma de decisiones en todos los campos de la ciencia, desde el otorgamiento de financiamientos, la promoción académica, la publicación de artículos hasta la designación de los ganadores del Premio Nobel (Smith, 2006). En el campo de las revistas científicas es común que se recurra a la revisión por pares tanto para determinar la validez de las ideas en cuanto a la originalidad, calidad y la pertinencia de la información que se reporta en los manuscritos enviados a las revistas científicas, así como para estimar el impacto potencial que tendrá en el mundo de la ciencia. Tan común se ha vuelto que ahora se ha convertido en un estándar que en la actualidad forma parte central del procedimiento de validación de la producción científica, y lo que es más importante, aceptado por la mayoría de los científicos. Las razones que ellos argumentan es que la revisión por pares conlleva mejoras sustanciales en el contenido científico y estadístico del manuscrito, las referencias que faltan o son inexactas, así como en las cuestiones de presentación y de uso del lenguaje (Ware, 2011). Entre las diferentes formas de evaluación por pares la más venerada es la técnica de doble ciego, aunque no siempre practicada por las revistas científicas, debido a que se parte de la idea de que es una técnica que permite evaluar de manera independiente, imparcial y sin sesgos los manuscritos, otorgándole al revisor la libertad para expresar sus ideas y criticar abiertamente el manuscrito. El principal argumento que valida esta técnica es la creencia de que permite al revisor comentar libremente el manuscrito sin temor a las repercusiones, puesto que tanto la identidad del revisor como del autor permanecen ocultos unos de otros, lo que hace que los argumentos del revisor estén libres de prejuicios que sesguen consciente o inconscientemente sus juicios (Ware, 2008). El proceso de revisión por pares generalmente comienza con una evaluación inicial del manuscrito de parte del editor quien decide si puede publicarse en su versión original, o es necesario que se pase a una revisión por pares, que en el caso de ser doble ciego, el mismo editor asigna pares que él conoce o bien recurre a una base de datos de posibles revisores y de ahí selecciona los que son afines al tema (Martínez, 2012). En uno de los estudios más grandes realizado en el 2008 se evaluó las actitudes de 3,000 académicos sobre el valor que le asignan a la revisión por pares doble ciego, el 71% se manifestó a favor de este tipo de revisión ya que consideraron que ayuda a aumentar la calidad de la producción científica; sin embargo, en otro estudio, en donde se analizaron siete revistas médicas, se encontró que ni los autores ni los editores encontraron diferencias significativas en la calidad de los comentarios. Un hecho sobresaliente para el tema que nos ocupa, fue que a pesar de que se utilizó la técnica de doble ciego, los revisores pudieron identificar al menos uno de los autores del manuscrito en alrededor del 40% de los trabajos (Editorial de Nature, 2008). Un estudio más reciente reporta semejantes resultados y señala que es muy frecuente que los revisores deduzcan la identidad de los autores por el tema discutido en el manuscrito o por las referencias usadas en dicho documento (Martínez, 2012). Estos resultados indican que la revisión por pares doble ciego dista de ser un procedimiento infalible porque a pesar de los controles que se puedan instrumentar para mantener en el anonimato tanto al autor como al revisor, existen deficiencias e imperfecciones en el procedimiento, que en ocasiones desembocan en conductas antiéticas de ambos miembros de la diada. Estas conductas, por parte de los autores, pueden incluir falsificar los datos o las pruebas realizadas en el trabajo de campo, retomar las ideas o los textos de otras personas sin darles el crédito correspondiente, alterar la autoría ya sea incluyendo a un autor que nunca participó en la investigación, con el acuerdo implícito de que el autor incluido coloque al autor que lo incluyó en otro artículo que haga este último; conducta muy frecuente en los últimos años y más ahora que la s de un investigador se toma en función de la cantidad de artículos que publica al año, situación que repercute en la magnitud del estímulo económico recibido, o bien cuando es el caso, en la obtención de financiamiento a sus investigaciones por la productividad demostrada. Las conductas antiéticas por parte de los revisores o evaluadores abarcan desde omitir avales falsos, hasta bloquear las ideas, si el autor es un competidor del revisor, o demorarse en el dictamen del manuscrito sin algún motivo razonable, con la finalidad de ser los primeros en difundir y apropiarse, por no decir robarse, las ideas de un manuscrito que estén evaluando, obteniendo de este modo ventaja de su posición de evaluador. Los editores de las revistas científicas no están exentos de recurrir a prácticas inapropiadas entre las que se encuentran influir de manera negativa en el dictamen que hacen los revisores, mentir al autor durante el proceso de evaluación de su trabajo y adjudicarse la autoría de ideas o textos de un manuscrito sometido a evaluación (Lafollette, 1992). Al margen de estas prácticas inapropiadas, es innegable que la revisión por pares, sea ésta doble ciego o no, es una responsabilidad que los revisores deben tomar en serio para poder hacer aportaciones sustanciales que contribuyan a mejorar la calidad de la producción científica que se hace en el mundo, para que esta tarea no se asemeje, como señalaba Lock (1985), al lanzamiento de una moneda en donde la probabilidad de dictaminar favorablemente un artículo no sea ligeramente mayor que la esperada a sacarse la lotería, esto es a que se publique por casualidad. |

|

A principios de esta década ya se identificaba una crisis de la revisión por pares, no por la baja calidad de sus resultados, sino por el creciente número de manuscritos enviados a las revistas para su dictamen lo que ha ocasionado que en estos tiempos la demanda de revisión haya superado la oferta de quien la lleve a cabo (Fox & Petchey, 2010). Los intentos de resolver este problema y obtener revisiones oportunas en tiempos razonables han desembocado por lo general en apelar al altruismo y a la ética profesional de los revisores. Sin embargo, desde finales de los sesentas se habían encontrado evidencias contundentes de que este llamado era infructuoso y lo que más funcionaba era otorgar un estímulo económico a los revisores (Hardin, 1968). Sin embargo, el otorgamiento de estímulos económicos a los revisores origina que aparezcan sesgos que interfieren en los estilos de evaluación de los revisores que tienen un impacto directo en la forma en que la ciencia se divulga. El problema del sesgo y de la interferencia es preocupante si se toma en cuenta lo que Ziman (1968) decía, desde la década de los sesentas del siglo pasado, que los revisores se han convertido en la piedra angular del que depende la ciencia, por lo que el papel de los evaluadores en la consolidación del pensamiento científico de la época se vuelve medular, de tal suerte que se debe procurar disminuir cualquier sesgo en la evaluación de los manuscritos científicos. En la búsqueda por aumentar la calidad de los dictámenes se ha recurrido a investigadores expertos y cualificados en su área de conocimiento; sin embargo, esto no siempre ha producido los resultados esperados, ya que contrario a lo que se pudiera pensar, en un estudio que se ha vuelto tradicional en donde se analizaron 1,600 revisiones, se encontró que la proporción de revisiones de baja calidad eran mayores en evaluadores de alto estatus científico en comparación con revisores de menor estatus, puesto que estos últimos realizaban revisiones que fueron calificadas de mejor calidad (Stossel, 1985). Resultados similares se encontraron en el estudio de Black, van Rooyen, Godlee, Smith, y Evans (1998), en donde se evaluó la calidad de 690 opiniones que se emitieron a 420 manuscritos enviados a la British Medical Journal (BMJ). Los hallazgos mostraron que las características de los evaluadores tenían poca relación con la calidad de los comentarios. La regresión logística realizada a los datos mostró que el único factor significativo asociado con puntuaciones de mejor calidad fue cuando los revisores eran expertos en epidemiología y estadística, además, si eran investigadores jóvenes, por el contrario las revisiones hechas por los investigadores expertos o por miembros del consejo editorial fueron calificadas de peor calidad. Estos resultados son comprensibles si se observan a la luz de que los investigadores más prestigiados están ocupados en otras actividades propias de sus líneas de investigación y les queda muy poco tiempo para dedicarlo a la revisión de manuscritos científicos, por lo que en ocasiones piden ayuda a un colega para que evalúe una parte del trabajo o todo el manuscrito, como lo comprobó el estudio de Lock y Smith (1990) y más recientemente el estudio de Ware (2011). Como se desprende de estos estudios, al final de cuentas existe una alta probabilidad de que el manuscrito terminé en manos de un experto totalmente desconocido, que en el peor de los casos puede ser un rival del autor original. |

|

A partir de lo anteriormente mencionado, es evidente que la revisión por pares en un mundo en red enfrenta nuevos desafíos y oportunidades por lo que es necesario que se realicen innovaciones en el proceso para que se haga más acorde con los tiempos que se viven de interconexión y colaboración mundial, puesto que la creciente globalización de la ciencia tiene implicaciones muy grandes en la revisión por pares (Ware, 2011). La innovación en el proceso debe tomar en cuenta que ahora es posible recurrir a revisores de cualquier parte del globo para mejorar el contenido científico y estadístico, así como la presentación relacionada con el uso del lenguaje de los artículos que se publican. Al margen de esto, pero no menos importante, es la confianza que se proporciona a los lectores de una revista cuando conocen que los artículos que publica pasan por un proceso de revisión por pares. Sin embargo, en una cantidad considerable de revistas llamadas científicas existe una falta de transparencia en la forma en que operan y en los procesos editoriales que las constituyen, así como en la forma en que están organizadas. Unas más audaces, por lo general de acceso abierto (Open Access) en Internet, y que son financiadas en parte por el pago que hacen los autores para la revisión de sus artículos, los servicios editoriales de publicación que proporcionan dejan mucho que desear (Butler, 2013). Algunos autores que han publicado en esas revistas han mencionado que piensan que sus artículos fueron mal revisados y en el peor de los casos ni siquiera eso, ya que observaron que sólo pasaron a PDF la versión de Word del manuscrito enviado a la revista para su dictamen. La Revista Digital Internacional de Psicología y Ciencia Social (RDIPyCS), consciente de esta situación, asume el reto de hacer transparente todo el proceso editorial en la publicación de sus ejemplares y adopta como un valor agregado, una política científica-editorial de revisión abierta por pares, dejando a un lado la técnica de revisión por pares doble ciego que es común en la mayoría de las revistas científicas y que se ha prestado en algunos casos, como lo señala Butler (2013), a la revisión simulada. El desparpajo y la ligereza con la que tratan esas revista la evaluación de los manuscritos que les envían alcanzan en ocasiones niveles de irresponsabilidad altos. Están plagadas de artículos que no logran convencer de la validez científica, sea ésta interna o externa, ya no se diga que tenga una metodología más o menos rigurosa y acorde al tema de estudio. Otro elemento que ahonda la suspicacia hacia esas revistas es que publican artículos con errores graves de redacción que lo hacen poco claro y preciso debido a la carencia de orden lógico en el desarrollo de las ideas. La mayoría de las revistas, ya sea que se difundan por los medios tradicionales o bien vía Internet, con acceso restringido o abierto, declaran que siguen una política editorial de evaluación de los manuscritos recibidos de revisión doble ciego en la que autores y revisores no se conocen ni establecen comunicación directa entre ellos. En los sectores científicos progresistas actuales la connotación doble ciego se ha asociado a la realización de evaluaciones oscuras en donde la imparcialidad es lo menos que predomina. La de la RDIPyCS es alejarse de las evaluaciones oscuras sumarias y apegarse a un proceso de evaluación abierta que fomente la colaboración entre equipos internacionales de investigadores en diferentes áreas del conocimiento científico, y el mejor medio para hacerlo es generando las condiciones que propicien la aparición de relaciones académicas científicas abiertas entre autores/as y revisores de los manuscritos. Mediante la visibilidad del proceso de revisión por pares se busca mostrar la calidad de la revista y que sea sometida a un escrutinio público en línea en donde se tenga la oportunidad de opinar de ella de manera asincrónica, con diálogo entre los autores, los revisores, la comunidad científica y la sociedad civil en su conjunto. A pesar del escenario de oportunidad que se abre a la revisión abierta por pares, en la actualidad existen pocas revistas en el mundo que utilizan este procedimiento para evaluar los manuscritos científicos que reciben y en Iberoamérica al parecer no existe ninguna. La búsqueda exhaustiva que se ha hecho en la mayoría de las bases de datos y visitando los sitios Web de varias revistas, la política editorial que dicen seguir en la evaluación de los manuscritos es la revisión por pares doble ciego. Un consorcio editorial de acceso abierto, de los pocos que se han encontrado, en donde algunas de sus revistas realizan una revisión abierta por pares es BioMedCentral, entre ellas se encuentra la prestigiosa revista British Medical Journal (BMJ). Es posible que la poca cantidad de revistas que utilizan como política editorial la revisión abierta por pares se deba a que si bien los autores manifiestan una opinión favorable a este tipo de política, cuando se les pregunta que si enviarían sus contribuciones a revistas que utilizan este tipo de revisión pocos contestaron que sí lo haría, ya que existe una marcada renuencia entre los investigadores para hacer comentarios abiertos del trabajo de sus pares o bien en recibirlos de sus evaluadores (Greaves et al., 2006) Con la evaluación abierta por pares se busca transparentar las decisiones científicas que se toman en la revista para publicar los artículos, así como realizar un ejercicio de rendición de cuentas sobre los resultados que tienen sobre la ciencia los estilos de evaluación de los revisores. En el primer caso se asume la obligatoriedad de hacer pública la información para que las personas interesadas puedan revisarla, analizarla y, en su caso, usarla para formarse su propio juicio de la calidad del artículo publicado. Por su parte el ejercicio de rendición de cuentas que hace la revista busca informar a la comunidad científica sobre las decisiones tomadas acerca de los artículos que recibe para publicar y aportar evidencias encaminadas a justificar dichas decisiones. Por estar dirigida al servicio de la ciencia y de la sociedad en general, la revista tiene la obligación de mostrar sus acciones y sus resultados a la vista de todos, es una situación que implica una voz pasiva y una activa, es decir que deje ver, por un lado, y por otro, que se muestre. Atendiendo a este imperativo de transparentar la información científica, la RDIPyCS se difunde mediante una política de libre acceso y de revisión abierta por pares, extendiendo el principio de transparencia a su máxima expresión, al colocarla en la vitrina pública para que aquellos interesados puedan revisarla y analizarla, sometiéndola de esta manera al escrutinio de la opinión pública mediante el diálogo científico. La información abierta de la revisión por pares de los manuscritos proporcionará elementos suficientes para que el escrutinio transite desde la vigilancia, pase por el análisis que fundamenta las ideas del estudio, y llegue hasta la comprobación de las ideas científicas que se manejan, debido a que en su elaboración se incluirá no solamente la dimensión informativa (de cuál fue el resultado final de la revisión), como se hace tradicionalmente en la revisión por pares doble ciego, sino que irá más allá al someter al escrutinio la dimensión argumentativa de los revisores, esto es, las razones que dieron origen a la opinión que emitieron sobre el manuscrito evaluado. La generación de este diálogo público entre las distintas voces propiciará que aparezca de manera espontánea y natural (no como producto de un derecho de petición de los autores de los artículos) un episodio comunicativo riquísimo en significados que generará líneas de acción en donde se imbricarán simbióticamente la pasión científica y la razón, con una visión compartida dirigida a la consecución de una misma misión: contribuir a la generación de conocimiento científico confiable y válido. Mediante este ejercicio de rendición de cuentas, al abrir la revisión por pares, se da paso para que la calidad de la revista sea evaluada no sólo por parte de la comunidad científica en donde reside, sino también por la opinión pública para que se analice el contexto de explicación y justificación que alimentan las acciones que se llevan a cabo en su publicación, y se valoren los resultados obtenidos en su instrumentación como proyecto de la Universidad Nacional Autónoma de México (UNAM), materializándose de esta manera el derecho a la crítica y al diálogo que tenemos todos los individuos que nos dedicamos al cultivo de la ciencia, buscando contribuir al crecimiento del conocimiento de nosotros mismos y de nuestro entorno natural, social y espiritual. Con la búsqueda de la transparencia en las decisiones científicas mediante la rendición de cuentas se pretende que el lector juzgue por sí mismo la calidad de los artículos publicados en la RDIPyCS. Igualmente con el procedimiento de revisión abierta por pares se busca darle un sello de distinción y que el lector tenga la garantía de que los artículos publicados fueron revisados por pares, que aunque éstos puedan emitir opiniones divergentes sirven como punto de partir para que el lector se forme su propia opinión sobre la calidad y la importancia del artículo publicado. Si bien este procedimiento no ha mostrado de manera contundente que a través de él es posible seleccionar los mejores artículos, indiscutiblemente es una manera en que tanto los investigadores como los lectores y los autores utilizan para filtrar la literatura científica de dudosa calidad o la pseudo-ciencia, adjudicándole un sello de garantía de calidad a aquellos artículos o revistas que utilizan el procedimiento de revisión por pares. (Tenopir et al., 2010). |

|

Baste decir por el momento, puesto que el modelo de evaluación abierta por pares de la RDIPyCS se presentará a detalle en la sección editorial del próximo número de la revista, que las ideas principales que lo sustentan giran alrededor de cinco aspectos. Primero, los revisores ocupan una posición central, ya que se está consciente de que la calidad de la RDIPyCS depende de los dictámenes emitidos por los revisores. Segundo, la tarea de revisión debe encaminarse a hacer tan comprensible como sea posible el manuscrito más que en hacer un juicio sumario del mismo. Tercero, los comentarios se deben centrar principalmente en hacer sugerencias de las acciones que debería hacer el autor para mejorar su manuscrito. Cuarto, por consiguiente los revisores se deberán centrar en hacerlo más claro, fijando su atención principalmente en:

Finalmente el quinto aspecto que se le pide al revisor es que evite hacer comentarios destructivos y cáusticos. El modelo de evaluación abierta por pares de la RDIPyCS contempla la presentación de los resultados de los dictámenes hechos por los revisores mediante la realización de un meta-análisis descriptivo de los juicios emitidos a través de los procedimientos propuestos inicialmente por Glass (1976). |

|

Indiscutiblemente, la revisión de un manuscrito va más allá del simple dictamen sobre la posibilidad de su publicación, ya que su impacto se deja sentir en la forma en que la comunidad científica fija los parámetros de los avances de la producción de conocimiento. Además, determina las reglas de cómo hacer ciencia al ser el medio a través del cual se valora y se mide la calidad, factibilidad y credibilidad de la producción científica con base en la idea normal de la ciencia de la época. Desde una perspectiva sociológica es en un espacio de disputa de valores en donde es ejercido el poder por grupos pequeños quienes autorizan la publicación de los manuscritos en campos específicos del conocimiento (O´Connor, 2012). En la actualidad, en ese espacio el poder se hace sentir bajo una figura que han moldeado los administradores de la ciencia cuya característica principal es medir el impacto y la calidad de la producción científica en términos del número de veces que un artículo es citado y del factor de impacto de la revista en que se publica, en otros casos es usado, por cierto erróneamente, para medir la calidad de los autores e investigadores. Es de todos conocido la malsana costumbre que existe en algunos grupos de científicos de hacer citas estratégicas intercambiándose citar entre ellos para aumentar el número de citaciones a sus artículos. En este sentido resultó revelador el estudio de la revista Nature (van Noorden et al., 2014), en donde se encontró que el 43.8% de la producción científica que abarca el cúmulo de artículos publicados desde 1900 hasta nuestros días nunca ha sido citada. Esta cifra pone de manifiesto que la interpretación que se hace frecuentemente, en donde se relaciona de manera directa la calidad del artículo por el número de veces que se cita, es una generalización débil que en el mejor de los casos sólo estaría arrojando una pequeña luz sobre la calidad y el prestigio de la revista en donde se publican esos artículos, pero no la calidad del conocimiento científico generado. En los últimos años el procedimiento al que han recurrido las revistas para seguir abonando a la construcción de ese cúmulo de conocimientos científicos ha sido a través de la revisión por pares. Este procedimiento es el que se utiliza en la actualidad para determinar la originalidad, calidad y pertinencia de la información que se reporta en los artículos y para estimar su impacto en el campo científico. La revisión por pares doble ciego es la manera por excelencia que utilizan la mayoría de las revistas para dictaminar los manuscritos recibidos. Las ideas que lo sustentan es que es una manera de evaluar independiente, imparcial y sin sesgo, en donde el revisor puede hacer sus comentarios libremente fuera de prejuicios sobre los autores. Sin embargo, a pesar de estos ideales y de sus buenas intenciones existen evidencias contundentes (Alfaro-Toloza & Alcayaga-Urrea, 2013; Lafollette, 1992; Martínez, 2012; Tenopir et al., 2010; Ware, 2011) de que los revisores utilizan su poder anónimo para retardar la publicación de un artículo o incluso rechazar trabajos posiblemente competitivos que no encajan en su doctrina o paradigma afín. Esto forma parte de una conducta no ética ni científicamente aprobada que provoca daño al desarrollo de la ciencia. Otro procedimiento para llevar a cabo la evaluación de los manuscritos científicos es la revisión abierta por pares, la cual representa una alternativa para dejar de fomentar conductas poco éticas y desterrar de la ciencia las evaluaciones oscuras y los juicios sumarios tras vestidores. Uno de los beneficios de direccionar una revista hacia este procedimiento abierto de revisión es contribuir al surgimiento de relaciones académicas científicas abiertas entre autores y revisores. Esta visibilidad del proceso de dictamen y de los revisores reduce significativamente las malas prácticas en la revisión al transparentar este proceso y permite someter a escrutinio y a la opinión pública todas las decisiones que se toman en la publicación de un artículo. El compromiso que asume ante sus lectores y la comunidad científica la RDIPyCS es hacer visible y transparentar sus decisiones rindiendo cuentas del proceso editorial de todos los artículos que se publiquen en cada número con el propósito de que cada lector revise dicho proceso y se forme su propio juicio sobre la calidad del artículo y de la revista. Para llevar a cabo esta tarea, la revista utiliza un modelo de evaluación que se sustenta en cinco aspectos principales que son: (1) el papel central que tienen los juicios abiertos de los revisores en el proceso de dictamen (2) la empresa de hacer más comprensible conforme al lenguaje formal y de la ciencia el manuscrito más que dirigirse a hacer de él un juicio sumario, (3) centrar las sugerencias en cómo mejorarlo más que resaltar sólo los errores, (4) realizar una lista de los cambios necesarios que se deben hacer al manuscrito, y (5) evitar hacer comentarios destructivos y cáusticos. En cuanto al enfoque, el modelo de evaluación gira alrededor de tres dimensiones: una textual, otra interaccional y finalmente una formativa. Con la primera se busca evaluar la claridad del escrito, con la segunda, que el autor interaccione para lograr un producto de mejor calidad, y con la tercera, afinar las cuestiones teóricas, metodológicas y aplicadas del manuscrito. Por su parte el método de evaluación del modelo abarca un componente cuantitativo y cualitativo, el primero de ellos es una especie de escala Likert compuesta de 199 preguntas que son valoradas de acuerdo a seis niveles de apreciación que son “Muy satisfactorio”, “Satisfactorio”, Deficiente”, “Muy deficiente”, “No aplica” y “No está desarrollado”. En cuanto al componente cualitativo es la sección en donde se recogen en forma de prosa las opiniones y sugerencias de los revisores sobre el desarrollo y la validez de las ideas manejadas en el manuscrito, que deberán incorporarse para que de esta manera sea publicado. Los resultados cuantitativos del proceso de revisión de los manuscritos se incluye al final de cada artículo en forma de un meta-análisis mediante figuras que van describiendo uno a uno los juicios que emitieron los revisores sobre cada parte que constituye el artículo publicado. Por otro lado, el producto del análisis cualitativo se publica en un sitio. Cada opinión y juicio de los revisores permanece publicado ofreciendo la posibilidad de ser comentado por cualquier persona en el sitio Web. Para conocer la forma que adquiere este proceso diríjase al siguiente vínculo. En resumen, el modelo de evaluación abierta de la revista está explícitamente orientado por criterios de interacción académica y fundamentado en instrumentos válidos, confiables y de acceso público. Este modelo de revisión abierta por pares puede no ser el mejor, pero es un primer esfuerzo que en el futuro se irá perfeccionando, para hacer más transparentes las decisiones científicas y evitar con esto, en lo posible, que esta revista se convierta en un medio que aumente sólo la cantidad de publicaciones de los investigadores, al margen de la calidad de su producción, y no se vaya a caer paradójicamente en favorecer la improductividad a nivel cualitativo relacionada con la calidad de lo que se publica y más aún considerando, como señala Ribes (2009), que el modelo empresarial que rige ahora a la ciencia mide la fuerza de trabajo principalmente por el número de publicaciones y que actualmente se le han agregado dos parámetros más que es el número de veces que es citado el artículo y el impacto de la revista en donde es publicado. |

|

La revisión por pares es en la actualidad el corazón del proceso científico y se ha convertido incuestionablemente en una herramienta que bien dirigida ayuda más a mejorar los manuscritos científicos que a clasificar o identificar aquellos defectuosos o fraudulentos (Smith, 1999). La búsqueda de nuevas alternativas de evaluación de los artículos ha conducido a la revista Nature, con una de la más importantes trayectorias científica y de mayor prestigio internacional, a cambiar en varias de sus filiales su proceso de dictamen y ahora algunas de ellas ofrecen a los autores/as la posibilidad de elegir entre una revisión doble ciego o una simple ciego. Esta opción la ofrece desde junio de 2013 la revistas Nature Geosciencia y Nature Climate Change y a partir de noviembre de 2014 y marzo de 2015 las revistas Nature Medicine, Nature Structural and Molecular Biology, Nature Cell Biology, y Nature Genetics (Editorial de Nature, 2014, 2015a, 2015b, 2015c, 2015d, 2015e). Esta situación muestra la relevancia que ha adquirido y el poder que se le ha otorgado a la revisión por pares convirtiéndose, hoy en día, en el medio a través del cual se admiten los avances científicos y en el plano personal son los que ayudan a los investigadores a progresar sus respectivas carreras académicas y profesionales (Posteguillo & Piqué-Angordans, 2007). Pero así como cimienta carreras y las fortalece también puede acabarlas cuando se descubren los fraudes que en ocasiones hacen los investigadores con sus datos. Un hecho muy sonado y documentado fue la supuesta clonación de seres humanos (Editorial de Nature, 2006). La tormenta de dudas también ha alcanzado a la psicología, principalmente en el área de psicología social experimental relacionada con los estudios de cómo las señales sutiles pueden influir inconscientemente nuestros pensamientos o conocimientos, conocida como “Social-priming”. El escepticismo ha alcanzado tal magnitud que hasta el Nobel de Economía (2002), Daniel Kahneman psicólogo de la Universidad de Princeton en New Jersey, mediante una carta que se publicó en la Revista Nature, señala la interrogante que se ha creado alrededor de esta área de la psicología (Yong, 2012). El origen de la interrogante que se ha levantado se debe principalmente a la noticia que apareció a finales del mes de octubre de 2011 en donde se publicó el informe que confirma el fraude que hizo, con la finalidad de promocionar su carrera, en varios de sus artículos el investigador holandés Diederik Stapel, algunos de ellos publicados en las revistas de mayor prestigio internacional como son Nature y Science. Es indiscutible, señala en su carta, que en esa área se avecina un choque de trenes debido a la tormenta de dudas que ha desatado el debilitamiento de los resultados de esa área de conocimiento de la psicología y recomienda que para rescatar la credibilidad se diseñe una serie de replicaciones para comprobar los resultados (Kahneman, 2012). Estos fraudes, además de acabar con la vida académica de quien los hace, erosionan los cimientos de la imagen romántica del científico, que según esta idea, vive consagrado a la búsqueda desinteresada de la verdad para mejorar la comprensión del universo que nos rodea, con el único interés de hacer uso de ese conocimiento que lleve al mundo hacia un futuro mejor. Sin embargo, el científico como cualquier ser humano tiene la pulsión de aumentar su ego, su estatus en la comunidad científica y, en ocasiones, motivaciones más mundanas como nutrir sus bolsillos. Es posible que la aparición de estas acciones poco éticas sean producto de la tendencia que existe en los círculos científicos de medir la competencia y valía académica a partir de las publicaciones, lo que ha favorecido el principio de publicar “por encima de todo y a cualquier precio”, o bien como señala Ribes (2009), publicar todo aunque sea impublicable, bajo el lema de “publish or perish” (publicar o morir). Estos hechos que cimbran la ciencia y dañan sensiblemente la credibilidad de los científicos han ocasionado que las revistas en donde se difunde la ciencia se planteen un cambio de rumbo en la forma en que son evaluados los manuscritos científicos. En el caso de la RDIPyCS la alternativa que se toma es la revisión abierta por pares, que si bien no es un procedimiento infalible para evaluar la calidad de los manuscritos, ni para detectar comportamiento poco ético de los investigadores y sus debilidades; sin embargo, como señala Smith (2006), es un sistema lleno de problemas, al igual que la democracia, pero cuando menos es lo menos peor que se tiene. Ante esta situación lo mejor es dirigir los esfuerzos para mejorar el procedimiento, igual como se hace con la democracia, más que abandonarlo. Por el momento y dado el estado de cosas, la evaluación abierta por pares se fundamenta más en la fe de sus efectos y la confianza, más que en la verdad de los hechos debido a que existe poca información que sustente sus beneficios, pero aun así la RDIPyCS se inclina por usar este procedimiento de revisión abierta de los manuscritos apostándole al diálogo entre el autor y los revisores, así como a la transparencia que conlleva informar a nuestro lector sobre la base de cómo se toman las decisiones de lo que se publica en la revista. Con esta acción se tiene la expectativa de lograr un avance sustancial en la transparencia de las decisiones científicas, ya que hay indicios de que ésta aumenta cuando se hace a través de procedimientos abiertos (Rühli, Finnegan, Hershkovitz, & Henneberg, 2009). Las ventajas de hacer esto, tomando las ideas de Pöschl (2010) son que la discusión de los manuscritos ofrece la posibilidad de establecer un discurso libre y de rápida diseminación sobre resultados sobresalientes y opiniones originales, sin revisiones que se atrasen y que se pierdan las ideas que se manejan en el manuscrito y su carácter novedoso.

Estas ventajas de la revisión abierta por pares trae aparejado retos, como el señalado por Pulverer (2010), en el sentido que muchos revisores no quieran arriesgarse porque sus nombres serán conocidos por el autor/a o bien por el temor a las represalias. Igualmente, puede promover actitudes menos críticas de los investigadores jóvenes temerosos de las posibles repercusiones cuando se les solicita revisar el trabajo de colegas más experimentados que son conocidos por éstos últimos (Editorial de Nature, 2015d). A pesar de estos riesgos bien vale la pena abrir todo el proceso de dictamen de los manuscritos y que se muestre en la Web para que cualquier persona interesada lo vea y lo analice y que deje de ser la revisión por pares la caja negra en donde sólo se conoce que algo entra y que después sale una sentencia, como en las revisiones doble ciego, que los evaluadores permanecen ocultos tras las sombras del anonimato bajo el argumento de una supuesta imparcialidad. Evidentemente la revisión abierta por pares no está exenta de que surjan sesgos conscientes o inconscientes difíciles de identificar y controlar, que a lo largo de este escrito se han estado mencionando como serían rechazar un manuscrito por razones de género, hábitos para realizar citas, la existencia de conflicto de intereses; sin embargo, ningún procedimiento de revisión, sea este doble ciego o totalmente abierto, garantiza un proceso libre de prejuicios. |

|

| Cómo citar:APA6 | Silva, R. A. (2015). ¡Abramos el discurso científico! La revisión abierta por pares. Una opción para transparentar las decisiones científicas. Revista Digital Internacional de Psicología y Ciencia Social, 1(1), 15-31. |

Historial del Proceso Editorial